Social Media Intelligence tra Giornalismo e sviluppi futuri

L’analisi che ho condotto insieme a Pier Luca Santoro e con la collaborazione dei preparatissimi Clarissa e Matteo è stata tra i post più ricondivisi in rete durante le giornate della sesta edizione del Festival Internazionale del Giornalismo.

Si è trattato di un monitoraggio in tempo reale del flusso dei tweet provenienti per l’hashtag #ijf12, oltre 25.000 in 5 giorni, a cui poi è seguita un’analisi per sintetizzare le informazioni più rilevanti con un approccio scientifico, a metà tra il data journalism e la statistica applicata ai media, con la presentazione dei risultati attraverso visualizzazioni come mappe, tag cloud, classifiche e tecniche di content curation, in modo da rendere fruibili le informazioni anche ad una platea non accademica.

Ieri ho avuto l’occasione di condividere l’esperienza passata durante il Festival grazie a Donato, che ha condotto un felice esperimento di Hangout Brand sulla pagina del suo blog Markingegno, invitando me ed altri amici a parlare proprio della Social Media Analysis che abbiamo condotto per il Festival. Cerco di spiegare di seguito come.

L’informazione si apre con le API

Se è stato possibile monitorare i tweet inviati per l’evento, questo è dovuto all’apertura del social network Twitter, che a differenza di Facebook che è un sistema quasi interamente privato, è invece quasi interamente pubblico. Infatti, se Twitter non aprisse la sua banca dati questo tipo di analisi sarebbe stata impossibile.

Per chi volesse effettuare un’analisi per un evento o seguire una notizia importante come il Festival Internazionale del Giornalismo c’è inoltre da considerare che ci sono dei limiti per l’utilizzo intensivo delle API di Twitter – attualmente un massimo di 350/tweet all’ora – ma è possibile superare notevolmente questi limiti (fino ad arrivare a 20.000 tweet / ora) se si è aggiunti da Twitter sull’elenco degli sviluppatori in whitelist. Nel nostro monitoraggio siamo riusciti a superare questo limite associando la nostra applicazione ad una doppia autenticazione oAuth, tramite un account Google Docs associato ad un’applicazione collegata ad un profilo Twitter.

Da ricordare comunque che non è possibile effettuare ricerche su Twitter riferite al passato (ed anzi, credo che uno dei potenziali modelli di business per Twitter sia proprio la vendita di questa sterminata miniera di dati storici). Altri Social che aprono la propria banca dati agli sviluppatori sono Foursquare, Instagram e Klout.

Tag Cloud

Per realizzare le singole tag cloud, in particolare in italiano, è necessario avere una lista di stop words (le stop words sono parole talmente comuni da non avere alcuna tipicità e rilevanza, mentre una buona tag cloud deve avere parole come dicono gli anglosassoni “content bearing”, ovvero portatrici di contenuto). Una lista di stop words in italiano si trova all’indirizzo http://snowball.tartarus.org/algorithms/italian/stop.txt. Per realizzare le tag cloud preferisco tagxedo.com che attualmente è in beta e che permette di utilizzare forme personalizzate ed ha una buona selezione di font. Altri servizi da segnalare sono http://tagul.com/ che permette anche un accesso API e il celebre wordle.net. Per gestire il testo è inoltre necessario suddividerlo in token, i più piccoli pezzetti di informazione che compongono il testo (le parole separate e senza punteggiatura). Per l’analisi abbiamo elaborato i dati, principalmente utilizzando excel, ma avremmo potuto utilizzare anche un software statistico open source come R. E’ necessario, oltre ad avere una profonda conoscenza della semantica e dell’analisi logica di un testo, saper gestire informaticamente grandi volumi di dati (con file anche molto pesanti).

Mappe di Social Network Analysis

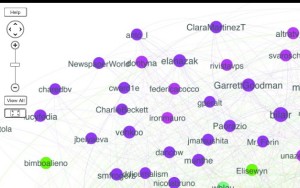

Tanto si è dibattuto anche intorno alla mappa di Social Network Analysis pubblicata l’ultimo giorno del Festival. Mi è stato chiesto cosa rappresentassero i vari colori dei nodi: si tratta di “cluster” o gruppi di nodi che hanno interagito di più tra di loro, attraverso Retweet, conversazioni e citazioni. E’ come la rappresentazione di una grande piazza in cui si evidenziano vari gruppetti di persone che si scambiano informazioni. In particolare in alto a sinistra in viola si evidenzia a mio avviso il gruppo dei partecipanti internazionali al Festival.

Per realizzare la mappa ho utilizzato Gephi, un software open source davvero fantastico! Qui c’è una splendida guida sulla realizzazione di una mappa di connessioni su Twitter. Un altro software utilizzabile è NodeXL che è disponibile solo per PC dotato di pacchetto Microsoft Office, come estensione per Excel. Martin Hawksey ha pubblicato un’utilissima guida per analizzare una mappa di Social Network Analysis con NodeXL. Per chi volesse approfondire segnalo anche il libro di Marc Smith, direttore della Social Media Research Foundation.

Open data

In piena filosofia Open Data al termine del festival abbiamo rilasciato la base dati utilizzata per realizzare l’analisi in un formato aperto (testo separato da tabulazione), in modo da lasciare a chi voglia la possibilità di fare altri tipi di approfondimenti. Rilasciare i dati, è l’equivalente di fornire le fonti per un giornalista: aumenta la veridicità delle informazioni e lascia aperti ulteriori progressi. A questo indirizzo su Google Fusion Tables potete visualizzare l’intera banca dati dei tweet inviati in occasione del Festival, con evidenziata la mappa dei tweet geolocalizzati in una mappa di calore: è possibile così notare i punti più caldi del Festival, dalla base centrale dell’Hotel Brufani a Corso Vannucci sino all’Hotel San Gallo.

Social Media Intelligence: il futuro?

Mentre a livello internazionale ormai la Social Network Analysis è entrata appieno tra gli strumenti In Italia siamo in pochi a fare analisi di questo genere, anzi oltre a Vincenzo Cosenza, che ho avuto il piacere di conoscere al Festival del Giornalismo e che è un veterano di questo genere di analisi e di altre ricerche (le sue mappe con i grafi di link ad esempio della blogosfera italiana per me sono fantastiche), non ne conosco altri e mi farebbe piacere anche in Italia si iniziasse a comprendere l’importanza di queste analisi.

Infatti sono numerosissimi i campi di applicazione: come strumento per i brand per posizionarsi all’interno del grafo sociale, come nuovo Auditel per scoprire il pubblico che segue i programmi TV, per la raccolta dati a basso costo per la creazione di smart cities (invece di installare costosi rilevatori per ottimizzare i flussi di persone in transito la stessa cosa si potrebbe fare tracciando le geolocalizzazioni sul web), in politica per le campagne elettorali o per misurare l’umore dei cittadini senza ricorrere a sondaggi… Ulteriori analisi che si potrebbero fare sono di tipo semantico e per la misura del sentiment, ancora molto difficile da fare in Italiano, ma su cui sto già indirizzando la mia ricerca, vista l’importanza di questo genere di valutazioni qualitative per l’analisi delle conversazioni pubblicate in rete. Come ottimo esempio di questo tipo di approccio, segnalo il lavoro di Roberto Favini, che ha analizzato molto bene le campagne di Pisapia e Moratti su Twitter.

Da ultimo, una considerazione dal punto di vista della Privacy. La miniera di dati a disposizione in rete è anche dovuta alla scarsa alfabetizzazione digitale dei cittadini, che non sempre sanno che stanno rendendo pubbliche molte più informazioni di quanto non si facesse sino a 10 anni fa. Nel Regno Unito il dibattito in questo senso è molto vivo: segnalo il recente ebook gratuito pubblicato da Demos, think tank su potere e politica, il primo ad esaminare la ricerca sui social media da un punto di vista etico e legale.